焊接机器人视觉传感器光轴夹角计算

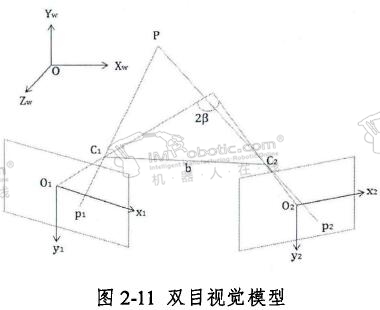

焊接机器人要计算光轴夹角,首先要建立双目视觉系统的模型,如图2-11所示。该模型主要实现空间三维坐标在到图像二维坐标的转换,O-XwYwZw是世界坐标系,O1-X1Y1以及O2-X2Y2分别为两摄像机对应相平面的平面坐标系。其中C1和C2为两个摄像机的光心,则两相机光心之间的连线b则称之为两相机的光心距离,而O1 C1与O2 C2的延长线相交得到的夹角2B则称之为两相机之间的光轴夹角。同时图中P(Xw, Yw, Zw)为空间中的任一点,P1(x1,y1)和P2(x2,y2)则为该空间点分别在两像平面上所成的像点。

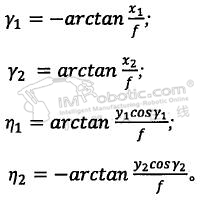

现称两像点P1和P2对其对应光心的水平视场角为Y1和Y2,垂直视场角为n1和n2。则由图2-11中相关几何关系可知,P点坐标为:

.jpg)

其中该式里:

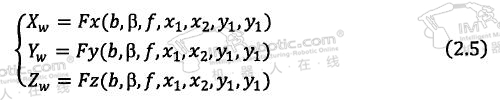

可以将式(2.4)简化成如下式(2.5)的形式,方便分析问题:

根据误差的合成与分配理论可知,空间点在三个坐标轴下的测量误差分别为:

其中该公式里各项参数分别表示为:

则根据公式(2.6)可得,空间点综合测量误差为:

式中:![]() 为综合误差传递函数,且

为综合误差传递函数,且

.jpg)

再由式(2.4)到式(2.8)联立可推出综合误差传递函数:

.jpg)

为了进一步分析光轴夹角的选择问题,由之前的选型可知,镜头焦距是一个确定的值,所以可以对光心距离b和光轴夹角邓对测量误差进行双因素分析。令△b=△B=w,根据公式(2.7),空间点的综合误差为:

式中:k为其他因素影响误差的折算系数。

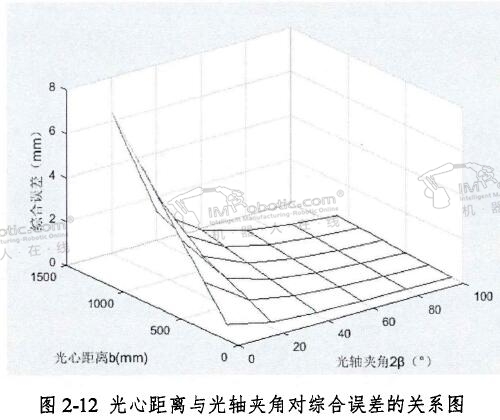

现在令wk = 0.00005, Y1=Y2=n1=n2=15°。则可以得出下图2-12。由图中我们可以知道,综合测量误差与光心距离成正比,与光轴夹角成反比,且随着基线距离的逐渐增大,增长的越快,随着光轴夹角逐渐增大减小的越平缓,且随着光轴夹角达到一定值的时候,总体综合测量误差已经可以看成微乎其微。所以总体综合测量误差可以由光轴夹角单独决定。

且由于之前计算光心距离的步骤中,出于Z方向理论分辨率的考虑,我们初定光心距离为150mm,介于此从图2-12中综合考虑,当光轴夹痛大于30°时,综合测量误差的下降幅度已经非常平缓,且总体的综合测量误差也在可以接受的范围之内。

同样由公共视野也可以确定光轴角度的大致范围。由公式((2.1)可以得出放大倍数约为40。又视场即相机成像面可以显示出的实际空问上的视野范围可以通过公式(2.11)求出,我们现在求视场上一个维度的大小,已知MindV sion公司的UV-300型CCD摄像机的分辨率为2048 X 1536,为了使相机无论在各种位姿下都可以较为全面的测到数据,现在取较小的那个维度即1536为视场维度。

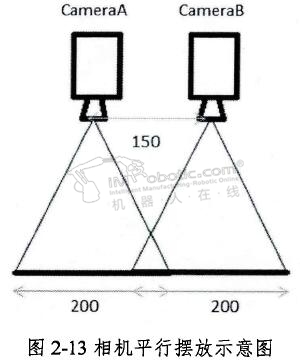

则FOV =40X5=200 mm。如图2-13所示,相机平行摆放,虽然在后续图像的立体匹配环境处理复杂度简单很多,但是此时两相机公共视场范围仅有50mm,在进行焊缝的轨迹跟踪环节,由于主要是采集经过焊缝的一小段线性光束,。是可以满足条件的。但是若后续迭代需要获取更多信息的时候,由于采集的信息较多,范围较大,在该视野下,获取的信息不足。所以两相机应该存在一定的大于0°的角度。

又通过(2.11)可知FOV=200 mm,又工件被拍摄高度也为200mm,由于光线的对称性,所以视野光线光心形成的三角形为正三角形。当两镜头间角度越来越大重叠视野越多,但获取总视野变少。又由于光线的对称和发散性,可以推知两镜头呈30°时,即镜头的最边端发散光线与竖直线共线,此时获取总视野和公共视野的大小都属于比较适中的状态。

所以通过以上论证,焊接机器人在设计传感器的时候,选择两镜头光心距离为150 mm,且两相机光轴夹角为30°。该传感器除了相机组之外,还包括激光器,激光器的高度和发射角度对图像质量也会产生一定的影响,但是由于激光器要根据工作情况和信号的前置时间的调整需要,并且激光器的角度和最后的成像效果之间可能做出理论性的数学推导,以及激光器的角度也是需要经常调整的,所以这里不对激光器的角度做多大限制,在结构上将其设置为角度易调整性,这样在面对不同的任务需求时候,可以通过手动调节参照图像显示信息,将激光器的角度设置为适宜工作需求的区间。

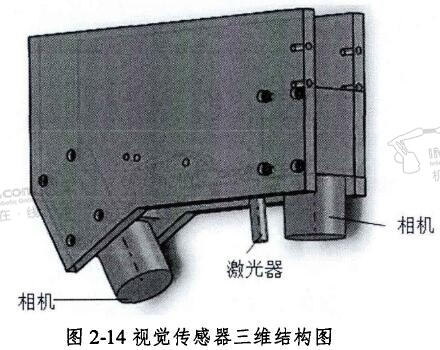

视觉传感器三维结构

根据上述分析与论证,可以得到双目视觉传感器系统设计的所需的部件选型以及部件空间分布的一些必备参数。下面依照这些数据,可以设计出如图2-14的视觉传感器的三维结构,其中包括两个相机和一个激光器,以及连接它们的固定板材。

好的文章,需要您的鼓励

8

- 最新资讯

- 最新问答

-

协作焊接机器人有哪些特点?优势是什么?

关键字: 协作机器人 焊接机器人 2025-08-13 -

工业机器人码垛工作站怎么布局?有哪些组成设备?

关键字: 码垛机器人 码垛工作站 工业机器人 2025-06-25 -

智能仓储系统的构成包括什么?有哪些特点?

关键字: 智能仓储 智慧物流 2025-05-15 -

微型压力传感器的原理是什么?有哪些应用?

关键字: 传感器 压力传感器 鑫精诚 2025-04-03 -

立体库堆垛机是什么?有哪几种类型?

关键字: 堆垛机 立体仓库 2025-03-24

-

焊接机器人系统组成有哪些?

标签: 焊接机器人,机器人系统 提问:李子 2025-07-24 14:02:05 -

高精度压力传感器关键技术有哪些?

标签: 压力传感器,传感器,鑫精诚传感器 提问:小王 2025-07-03 17:01:05 -

智能焊接机器人的优势有哪些?

标签: 焊接机器人,工业机器人,配天机器人 提问:小王 2025-06-04 14:03:04 -

自动装卸货机器人的组成部分有哪些?

标签: 赛那德机器人,装卸货机器人,赛那德 提问:李子 2025-05-28 11:03:03 -

激光焊接机器人的特点有哪些?

标签: 激光焊接机器人,焊接机器人,工业机器人 提问:小T 2025-04-15 11:02:00

- 2021-06-10 10:45:45

- 2021-06-11 13:34:28

- 2020-05-29 10:03:22

- 2019-09-24 11:19:01

- 2020-01-16 13:27:13

- 2019-03-22 15:42:15

- 2022-08-16 15:24:08

- 2022-09-04 12:21:15

- 2022-09-07 14:44:11

- 2022-09-12 21:10:37

- 2022-12-06 16:27:14

- 2022-08-03 10:20:40

- 2025-08-13

- 2025-06-25

- 2025-05-15

- 2025-04-03

- 2025-03-24

- 2025-03-17

- 2025-03-12

- 2025-03-05

- 2025-02-27

- 2025-02-19